#simpleit: Wie man eine Datenplattform ohne Budget aufbaut

by bernt & torsten

Dieser Artikel richtet sich an kleine Unternehmen, die möglicherweise kein dediziertes Datenteam oder nur eine einzige Ressource für den Betrieb einer Datenplattform haben. Der Schwerpunkt dieses Artikels liegt auf der Einrichtung einer Datenplattform für kleine Unternehmen. Dieser Artikel soll zeigen, wie Sie die beste Datenplattform für Ihre Organisation ohne Datenbudget erstellen können. Alles, was Sie brauchen, ist ein Laptop und ein bisschen technisches Know-how.

Bevor ich erkläre, wie man eine Datenplattform einrichtet, lassen Sie uns einen Blick darauf werfen, was die beste Datenplattform für Ihr Unternehmen wäre. Da Daten heute ein großes Thema sind, gibt es viele Artikel, die Sie über Datenplattformen usw. lesen können. Keine Datenplattform ist universell. Das Einrichten einer Datenplattform verwendet Bausteine, um eine Datenplattform einzurichten, die zu Ihrem Unternehmen passt.

Tatsache ist, dass eine Datenplattform für ein Unternehmen etwas anders aussieht als für ein anderes Unternehmen. Bei der Erstellung der besten Datenplattform für Sie und Ihr Unternehmen ist es wichtig, einige Fragen zur Kultur, zu den Geschäftszielen, zur Struktur und mehr Ihres Unternehmens zu beantworten.

Daten

Der Aufbau einer Datenplattform besteht darin, einige Fragen zu Ihrem Unternehmen zu stellen, d. h. benötigen Sie ein zentrales Repository für alle Daten Ihres Unternehmens, das die Erfassung, Speicherung, Bereitstellung und Verwaltung dieser Daten ermöglicht und gleichzeitig die Sicherheit über den gesamten Datenlebenszyklus hinweg gewährleistet. Werfen wir einen Blick auf einige der kritischeren Fragen?

Wie werden Sie das Buy-in der Stakeholder gewinnen?

Eine Datenplattform ist nur dann hilfreich, wenn ihre Nutzer – Stakeholder im gesamten Unternehmen – offen dafür sind und mit ihr vertraut sind. Bevor Sie eine Datenplattform erstellen, ist es wichtig, alle, die sie nutzen könnten, an Bord zu holen, bevor Sie eine Datenplattform erstellen.

Mitarbeiter in allen Bereichen des Unternehmens sollten verstehen, wie die Datenplattform ihnen letztendlich einen Mehrwert bietet. Das ist die anfängliche Aufgabe des Datenteams: diesen Wert zu erklären und zu präsentieren und eine Methode zur Erfolgsmessung zu etablieren, selbst wenn das Unternehmen skaliert.

Wem gehört was im Datenstapel?

Wie werden die Daten verwendet? Wird es sich um eine gemeinsam genutzte Ressource handeln, die im gesamten Unternehmen angezeigt wird? Wie die Daten des Unternehmens an verschiedenen Punkten im Datenlebenszyklus gehören: Das Datenteam kann beispielsweise Eigentümer der Rohdaten sein, bevor es sie an das Marketingteam zur Analyse und Einsicht weitergibt, die dann analysiert und auf ein Dashboard für das Führungsteam angewendet werden können.

Der End-to-End-Datenstapel besteht aus mehreren Bausteinen, die jedes dieser Teams unterstützen.

Wie messen Sie den Erfolg?

Beim Aufbau einer Datenplattform ist es wichtig zu messen, wie Stakeholder Daten nutzen können, um Geschäftsanforderungen zu unterstützen und die Qualität und Effizienz der Leistung des Datenteams zu ermitteln.

Werden Sie Ihre Datenplattform zentralisieren oder dezentralisieren?

Sollte sich Ihr Unternehmen für die Konsolidierung des Datenteams entscheiden? Wird die Zentralisierung zu viele Engpässe mit sich bringen? Wird ein dezentraler Ansatz zu Doppelarbeit und Komplexität führen? Zu verstehen, wie jede Option aussieht – und das beste Modell für Ihr Unternehmen auszuwählen, ist eine wesentliche Überlegung beim Aufbau Ihrer Datenplattform.

Wie gehen Sie mit Datenzuverlässigkeit und Vertrauen um?

Mit zunehmendem Datenvolumen wird die Datenzuverlässigkeit immer wichtiger. Unabhängig davon, ob Sie Ihr Datenzuverlässigkeitstool erstellen oder eines kaufen, wird es zu einem wesentlichen Bestandteil einer funktionalen Datenplattform.

Technologie

Schauen wir uns die technologischen Überlegungen an, über die Sie im Voraus nachdenken müssen, bevor Sie mit dem Aufbau einer Datenplattform beginnen. Hier sind einige meiner Gedanken zu diesem Thema:

Inkrementelles Denken

Der erste logische Schritt besteht darin, Ihre Datenplattform inkrementell zu entwerfen. Wenn ein bestimmter Schritt fehlschlägt, kehren Sie zum vorherigen zurück und vermeiden es, den gesamten Prozess neu zu berechnen. Beim Umgang mit großen Datenmengen werden Sie schnell feststellen, dass das Erstellen eines inkrementellen Stacks kein nachträglicher Einfall sein kann.

Lego Block Montage

Wenn Sie auf ein Problem stoßen, schreiben Sie einen Codeabschnitt, um es zu beheben, und ein innovativerer Ansatz besteht darin, vorhandene Bausteine zu finden, um dieses Problem stattdessen zu beheben.

Entwerfen Sie eine Datenplattform, die eine begrenzte Menge an Codierung erfordert. Je weniger benutzerdefinierter Code erstellt wird, desto besser ist das Unternehmen, insbesondere wenn Sie ein Datenteam mit einer Person sind.

Warum? Denn je mehr benutzerdefinierter Code Sie schreiben, desto mehr Code muss Ihr Unternehmen verwalten, desto mehr Komponententests müssen Sie durchführen und desto komplexer wird Ihr Code, um von anderen verstanden zu werden.

Suchen Sie stattdessen nach bereits vorhandenen Blöcken, die von den verschiedenen Komponenten Ihres Datenstapels, dem Orchestrator, dem Cloud-Anbieter, dem Warehouse usw., bereitgestellt werden, und stellen Sie sie zusammen, um Ihre Projektanforderungen zu erfüllen. Es wird billiger und einfacher zu warten sein, aber es wird Ihre Zeit für die Kernaspekte Ihrer Arbeit freisetzen.

Effektive Überwachung

Wenn Sie Ihre erste Datenpipeline erstellt haben, kann sie immer noch fehlschlagen – Die Einrichtung einer ordnungsgemäßen Warnung und Überwachung ist von entscheidender Bedeutung. Sie möchten sich der Dinge bewusst sein, wenn sie sich schlecht benehmen, bevor jemand anderes in Ihrem Unternehmen, Ihr interner Kunde, eine Beschwerde einreicht.

Richten Sie eine ausgezeichnete Alarmierungspraxis ein, die weniger, übergeordnete Warnungen generiert und diese als Produktionsvorfälle behandelt. Sie können ein Dashboard erstellen, das geschäftskritische Fehler anzeigt, sodass Fehler in der Reihenfolge ihrer Priorität behoben werden können.

Daten-Produkt-Management

Es kann erforderlich sein, dass Sie ein Ein-Personen-Datenteam sind, um die Data Product Management-Aufgabe zu verwalten. Data Product Management erfordert unterschiedliche Fähigkeiten. Während Sie die gleiche Empathie für Kunden haben sollten, benötigen Sie auch ein tiefes technisches Verständnis von Inputs und Outputs. Und natürlich, wenn Sie in einer SQL-Welt leben, benötigen Sie ein Gefühl für die Datenbankstruktur und SQL-Abfragen. Sie können all das haben, also machen Sie sich keine Sorgen.

Die Datenplattform

Meine Philosophie tendierte immer zu #simpleit, dem Prinzip, Systeme zu vereinfachen, indem ich so wenige IT-Systeme habe, die den kompletten Service eines Unternehmens bieten. Das gleiche Prinzip gilt für Datenplattformen.

Die Basispipeline

Die primäre Pipeline erfordert ein wenig Programmierung, um ein Datenextraktionsskript zu schreiben, und ich mache dies mit Python. Ich lade die Daten auch in eine MySQL-Datenbank, die auf meinem Laptop installiert ist. Dies ist kein geplanter Auftrag, daher müssen Sie ihn ausführen, wenn Sie neue Daten extrahieren. Ich verwende in diesem Szenario Google Data Studio, um eine Verbindung zu meinem lokalen Laptop herzustellen, um die Daten in einen Bericht zu ziehen.

Dies ist ein Beispiel für eine Datenpipeline, die Sie mit Ihrer eigenen Zeit einrichten können.

Die Basisdatenpipeline in der Cloud

Sie können dasselbe Skript verwenden und den Code anpassen, der als Cloud-Funktion ausgeführt werden soll, dann können Sie sich bei der Google Cloud Platform anmelden und eine geplante Datenpipeline in der Cloud ausführen. Je nachdem, wie oft Sie die Cloud-Funktion ausführen müssen, befinden Sie sich innerhalb des kostenlosen Kontingents, wenn Sie es 2 – 3 Mal am Tag als Batch-Job ausführen. Der einzige Unterschied zur Basic Pipeline besteht darin, dass wir anstelle von MySQL BigQuery verwenden und ein Scheduler-Setup haben. Ich verwende Cloud Storage auch als Data Lake, um Dateien der Extrakte zu speichern.

Die Open-Source-Datenplattform ohne Budget

Da die beiden vorherigen Beispiele grundlegender sind, müssten Sie Code für Ihre Pipeline verwalten, und wie ich bereits sagte, je weniger Code Sie verwalten müssen, desto mehr Zeit haben Sie für andere Aufgaben.

Als Ein-Personen-Datenteam in meinem Unternehmen basiert die ultimative Datenplattform, die ich verwende, auf zwei Open-Source-Tools, Airbyte und Superset. Diese beiden Mautgebühren sind Open-Source-Tools, und Sie können sie mit Docker ausführen.

Airbyte

Airbyte ist ein Open-Source-Datenintegrationstool, mit dem Sie mit nur wenigen Klicks alle Ihre ELT-Datenpipelines in wenigen Minuten einrichten können, sogar Ihre benutzerdefinierten, wodurch sich Ihr Team auf Erkenntnisse und Innovationen konzentrieren kann.

Mit Airbyte können Sie Ihre Quelle mit einem Ziel verbinden, das eine Datenverbindung herstellt. Es sollte nicht erforderlich sein, Code zu schreiben, da viele Quellen vorhanden sind und Zielkonnektoren bereits verfügbar sind. Wenn Sie Code für einen sehr benutzerdefinierten Quellconnector schreiben müssen, wird Airbyte mit einem Connector Development Kit (CDK) geliefert, mit dem Sie Ihren benutzerdefinierten Connector schreiben können.

Obermenge

Apache Superset ist ein Open-Source-Programm zur Datenexploration und -visualisierung, und Sie können auch Dashboards und Zeitpläne erstellen, um das Dashboard an Ihren Stakeholder zu senden.

Die Einrichtung der Datenplattform mit Docker

Die Einrichtung dieser Datenplattform auf Ihrem lokalen Schreibtisch / Laptop dauert nur wenige Minuten. Der erste Schritt besteht darin, Docker Desktop herunterzuladen.

Wenn Sie Docker Desktop installiert haben und ausführen, müssen Sie Airbyte und Apache Superset aus ihrem jeweiligen GitHub-Repository klonen.

Airbyte-Schnellstart

Der Airbyte-Schnellstart ist unkompliziert. Tun Sie einfach Folgendes.

$ Git Klon https://github.com/airbytehq/airbyte.git

$ cd airbyte

$ docker-compose upSuperset-Schnellstart

Lesen Sie für Superset die Superset-Dokumentation. Die Installation ist so einfach wie Airbyte:

$ Git Klon https://github.com/apache/superset.git

$ cd Superset

$ docker-compose -f docker-compose-non-dev.yml upDadurch werden Airbyte- und Superset-Container im Docker-Desktop gestartet:

Jetzt sind Sie bereit, diese leistungsstarke Open-Source-Datenplattform zu nutzen. Das Schöne an diesem Setup ist, dass ich die MySQL-Instanz, die ich lokal ausführe, zum Laden von Daten aus Airbyte verwenden und Superset verwenden kann, um ein Dashboard aus diesen Daten zu erstellen. Ich bin nicht darauf beschränkt, und ich kann immer noch den Airbyte BigQuery-Konnektor als Ziel verwenden und dann einige Berichte mit Data Studio erstellen.

Schlussfolgerung

Es ist eine sehr flexible Möglichkeit, Ihre Datenpipeline einzurichten. Sie können wachsen, indem Sie andere Bausteine wie dbt, Airflow usw. hinzufügen.

Wenn Sie ein kleines Team sind, beginnen Sie mit nur ein paar Lego-Blöcken für Ihre Datenplattform und wachsen Sie, wenn die Nachfrage steigt.

Ein Ratschlag, den ich habe, ist, mich nicht von neuen Werkzeugen mitreißen zu lassen oder von anderen bei Peer-Meetings oder Konferenzen beeinflusst zu werden. Folgen Sie der Richtung Ihren Weg, ohne diktiert zu werden. Je mehr Sie von anderen oder von neuen Tools beeinflusst werden, desto mehr Zeit wird von Ihrem Hauptziel abgezogen, eine Datenplattform für Ihr Unternehmen bereitzustellen. Bitte halten Sie sich von sehr eigensinnigen Kollegen fern, da dies nicht immer die beste Richtung ist.

Wenn Sie eine Ein-Personen-Datenabteilung oder ein kleines Team sind, haben Sie keine Zeit, mit anderen Tools und Technologien zu lernen und zu kämpfen. Mit diesen Tools gelangen Sie direkt in die guten Dinge Ihrer Transformationen – nichts, was Sie einrichten und verwalten müssen.

Tech Disillusionment

For four decades, I have worked in the tech industry. I started in the 1980s when computing...

A Poem: The Consultant's Message

On a Friday, cold and gray,

The message came, sharp as steel,

Not from those we...

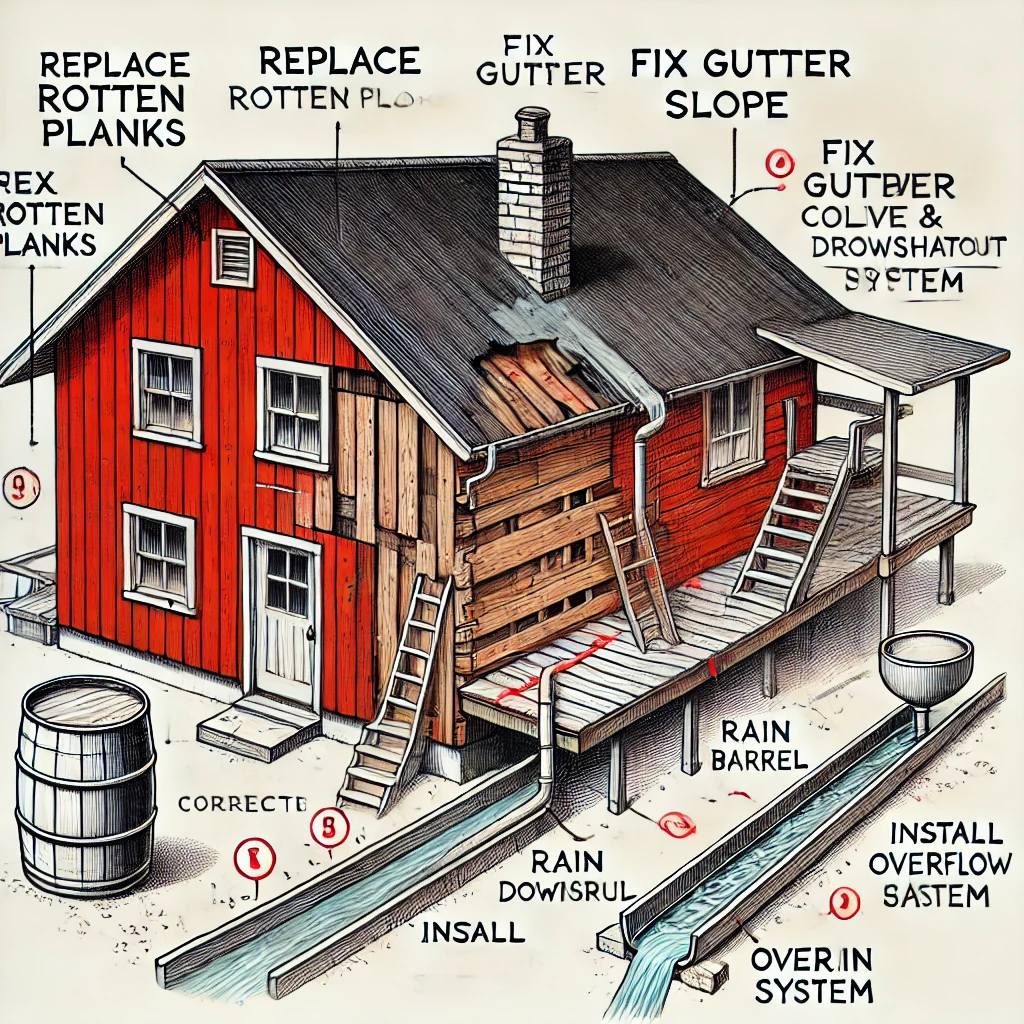

Using AI to Plan Wall Repair and Gutter Installation

In this article, I will share my experience using AI to plan the work required to fix a wall...